La IA en la atención médica exige vigilancia ética, equilibrando la innovación eficaz con la promesa fundamental de la medicina: no causar daño. Descubra qué se necesita para implementar la IA en la atención médica de forma responsable.

El médico y filósofo griego Hipócrates introdujo los conceptos de la medicina moderna, estableciendo la medicina como una ciencia basada en la observación cuidadosa de los síntomas del paciente y datos empíricos, en lugar de la superstición. Pero Hipócrates hizo más que simplemente separar la medicina de la magia; se le atribuye haber incorporado la ética a la ciencia de la medicina, como se establece en el Juramento Hipocrático, que establece, en parte, «Primero, no hacer daño». Aproximadamente 2500 años después, los médicos realizan el Juramento Hipocrático como compromiso de cuidar a los pacientes, aliviar el sufrimiento, usar sabiamente su conocimiento y criterio, y evitar causar daño.

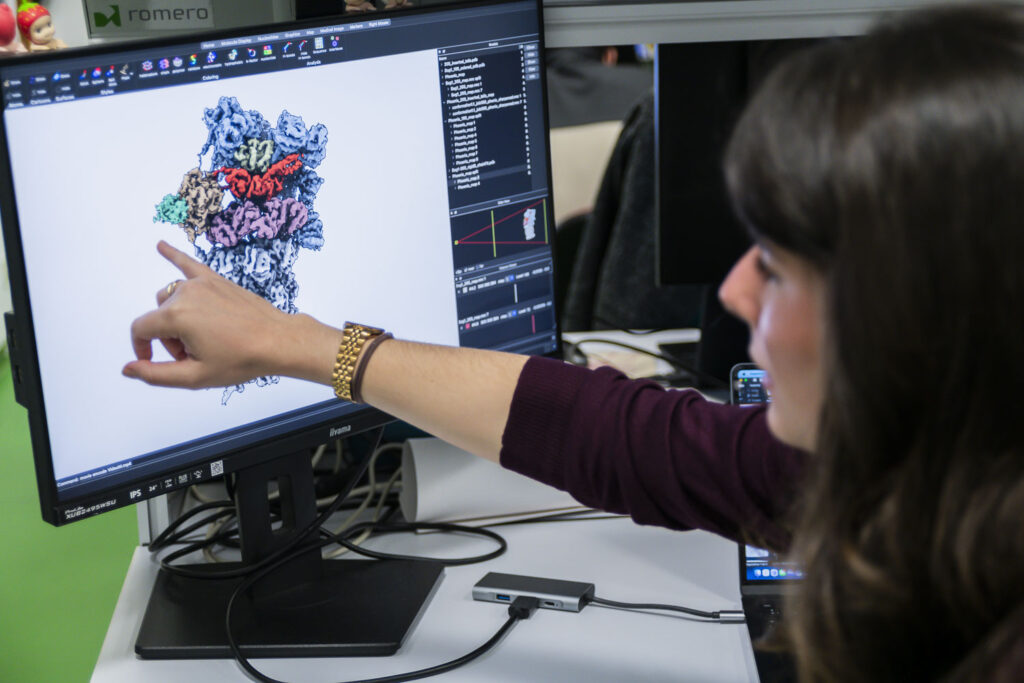

Los médicos modernos disponen ahora de una extraordinaria gama de herramientas y tecnologías, y el espectacular auge de la inteligencia artificial (IA) promete nuevas y potentes capacidades analíticas y diagnósticas. La IA es una tecnología informática avanzada capaz de procesar grandes cantidades de datos médicos, aprovechando el conocimiento colectivo de innumerables médicos y profesionales de distintos continentes y siglos. Las tecnologías de IA utilizadas en el ámbito sanitario tienen el potencial de ofrecer diagnósticos más tempranos, rápidos y precisos; monitorizar a los pacientes en tiempo real; y predecir las vías para obtener los tratamientos farmacológicos y procedimentales más eficaces para lograr una atención superior al paciente.

Pero la prisa por adoptar la tecnología e integrar los sistemas de IA en la atención médica general conlleva serias preocupaciones éticas. En otros sectores (como las redes sociales), los datos confidenciales de los usuarios se recopilan y utilizan rutinariamente para influir en la publicidad, influir en la opinión pública y generar ingresos, a menudo sin el permiso de los usuarios involucrados y sin tener en cuenta cómo esta divulgación podría afectarles.

En consecuencia, la industria sanitaria se enfrenta a consideraciones éticas cruciales al utilizar sistemas de IA. En primer lugar, es responsable de garantizar la protección de los datos confidenciales de los pacientes de acuerdo con las obligaciones regulatorias vigentes, como las normas de privacidad de datos de pacientes. En segundo lugar, es responsable de garantizar que los datos de los pacientes se utilicen adecuadamente para que los proveedores de atención médica y los sistemas de IA no causen daño.

¿Por qué es importante la ética al utilizar IA en la atención médica?

Las cuestiones éticas relacionadas con el uso de la IA en la atención médica conllevan implicaciones tanto técnicas como morales. Para realizar su trabajo, los profesionales de la salud utilizan amplios conocimientos, que a su vez deben aplicar de forma justa y equitativa en beneficio de todos los pacientes. La IA dista mucho de ser perfecta, por lo que los profesionales deben ser cuidadosos al aplicar los principios éticos a su uso. Las cuestiones éticas en la aplicación de la IA al conocimiento médico se centran en tres áreas principales.

1. Precisión

Los sistemas de IA pueden analizar enormes cantidades de datos para identificar tendencias y ofrecer diagnósticos mucho más rápido que los profesionales humanos, pero deben entrenarse con ejemplos de afecciones conocidas, ya que la IA solo puede aprender lo que se le enseña. Además, la exactitud de las conclusiones de la IA debe reforzarse y optimizarse con la retroalimentación de los profesionales. La IA comete errores y tiene el potencial de generar conclusiones falsas, un fenómeno conocido como alucinación de la IA . Esto significa que la asistencia de la IA en la atención médica nunca debe tomarse al pie de la letra. Su información puede salvar vidas, pero sus conclusiones siempre deben ser examinadas y validadas por expertos humanos.

2. Equidad

Las conclusiones de la IA son tan buenas como los datos subyacentes. Desafortunadamente, los datos suelen ser imperfectos, con defectos que incluyen información incompleta, inexacta y sesgada. Estos defectos pueden afectar negativamente la toma de decisiones de la IA, reduciendo la precisión de sus conclusiones, especialmente si los datos subrepresentan a los pacientes en función de su clase social, raza, género, religión, orientación sexual o discapacidad. Esto hace que la calidad de los datos y la mitigación de sesgos sean cuestiones centrales en el desarrollo y el entrenamiento de la IA.

3. Seguridad

La IA se distingue por su capacidad para acceder y procesar enormes cantidades de datos, así como para actuar según sus conclusiones con una autonomía asombrosa. Esto ejerce una enorme presión sobre la seguridad de los datos, necesaria para proteger los datos confidenciales de los pacientes del acceso ilegítimo o inapropiado, tanto por parte de la IA como de sus usuarios, y para garantizar que los datos utilizados para entrenar los sistemas de IA se anonimicen correctamente, de modo que las condiciones y los resultados no se puedan asociar a pacientes específicos. Si bien los problemas de seguridad son, en parte, competencia de los profesionales de TI, abordar la seguridad de la IA requiere un enfoque holístico que abarque a profesionales, administradores e investigadores. Además, debe reforzarse con formación continua de concienciación y desarrollo de políticas.

Consideraciones éticas al utilizar la IA en la atención sanitaria

Hay cuatro consideraciones éticas clave para garantizar que las empresas de atención médica basadas en IA utilicen las herramientas de IA de forma inteligente y en beneficio de los pacientes. A continuación, explicamos cómo abordarlas.

Creación y aplicación de políticas éticas

Se necesitan marcos de políticas detallados para guiar el uso de los sistemas de IA, traducir las recomendaciones de IA a la práctica clínica y garantizar la transparencia y la explicabilidad de la IA . Las políticas enfatizan el uso ético de la tecnología de IA para beneficiar a los pacientes, a la vez que previenen daños o malversaciones. Dichas políticas a menudo incluyen debates sobre factores como el consentimiento del paciente, la igualdad de acceso a la atención, los errores de IA, el sesgo de IA y el mal uso del sistema de IA. Las políticas a veces incluyen debates sobre el contacto con los pacientes para garantizar que el uso de IA no los deshumanice y que las recomendaciones individuales de IA sean precisas y confiables antes de su implementación.

Mantener la seguridad de los datos y la privacidad del paciente

La IA puede acceder y procesar cantidades abrumadoras de datos, que deben almacenarse e identificarse. Con sólidas normativas y leyes vigentes para proteger la información personal identificable de los pacientes, los requisitos éticos incluirán factores como obtener el consentimiento del paciente sobre cómo se recopilan y utilizan los datos, recopilar la cantidad mínima de datos, seguir protocolos de almacenamiento y seguridad de datos (como el cifrado de extremo a extremo), utilizar herramientas de gestión de identidades y accesos (IAM) e implementar medidas de copia de seguridad de datos y recuperación ante desastres. Las consideraciones éticas también deben explorar maneras de prevenir y mitigar eventos como el uso no autorizado de sistemas de IA.

Aplicación de la supervisión humana a las recomendaciones de IA

Es fácil confiar simplemente en el sistema de IA e implementar sus resultados, pero la confianza ciega en la automatización, especialmente en sistemas con errores y sesgos, puede tener consecuencias devastadoras para los pacientes y las organizaciones sanitarias. Las consideraciones éticas detallarán la necesidad y la aplicación de la supervisión humana en varios niveles. Por ejemplo, los profesionales deben revisar las recomendaciones de IA para garantizar su precisión y validar las decisiones de IA verificando la explicabilidad del resultado y considerando cuestiones subjetivas como las preferencias y los valores del paciente. Además, se debe considerar cuidadosamente la responsabilidad y otras cuestiones legales que afectan a toda la cadena del sistema de IA, incluyendo a los desarrolladores de sistemas de IA, los formadores de IA, los médicos, los administradores y demás personal. La formación regular en el uso adecuado y aceptable de las herramientas de IA forma parte de esta consideración.

Garantizar una experiencia positiva para el paciente

La ética también se extiende al tratamiento del paciente en varios niveles, incluyendo la empatía y la sensibilidad al recopilar información, reconocer y respetar sus preferencias y valores, y hacer un seguimiento de sus resultados, así como de la calidad percibida de la atención. Parte de la participación del paciente también incluye su consentimiento claro y conciso, que describe la información recopilada, su necesidad y cómo se utiliza (incluido el entrenamiento adicional en IA, si es necesario), y permite a los pacientes optar por no participar en ciertos usos de sus datos.

Desafíos de las integraciones éticas

La ética es fundamental para todo tipo de prácticas de atención médica, pero la integración de preocupaciones éticas en los sistemas de IA puede presentar varios desafíos generales para las organizaciones, incluidos cuatro obstáculos principales que se describen a continuación.

1. Falta de liderazgo

Un problema fundamental con la IA y la ética es la idea de que las cuestiones éticas se abordan como parte inherente de la plataforma de IA; en otras palabras, que el simple uso de una plataforma de IA se correlaciona con prácticas éticas. Esto no es así. Los sistemas de IA no tienen una dirección ética o moral automática y funcionarán independientemente de cómo se utilicen. Por consiguiente, el uso ético de la IA debe comenzar desde la cúpula de la organización sanitaria, con la alta dirección reconociendo la necesidad de adherirse a los estándares éticos y emitiendo el mandato para el uso ético de los sistemas de IA.

Los líderes del sector salud que buscan una integración exitosa de la ética y la IA generalmente se centran en comprender los riesgos de la IA relacionados con factores como la seguridad, la propiedad y la calidad de los datos, el sesgo en los datos, el consentimiento informado del paciente, la rendición de cuentas y la responsabilidad. Una vez comprendidos los riesgos principales, el equipo directivo puede elaborar políticas que guíen la implementación y el uso de los sistemas de IA .

2. Falta de políticas

El uso ético de la IA en la atención médica se basa en políticas cuidadosamente planificadas que abordan cuestiones como la seguridad de los datos y la protección de los datos de los pacientes, la retención de datos, los estándares de validación clínica (es decir, garantizar que la IA sea correcta en sus conclusiones), la calidad de los datos y la mitigación de sesgos. Las políticas establecen las normas para el uso de los sistemas de IA y sus datos subyacentes, de acuerdo con los estándares éticos de la atención médica. También ayudan a garantizar el cumplimiento de las obligaciones regulatorias y de responsabilidad.

Sin embargo, las organizaciones sanitarias suelen incumplir el desarrollo, el mantenimiento y la formación de los profesionales sanitarios sobre estas políticas. La ausencia de políticas o su incompleción conllevan un uso inaceptable de la IA, ponen en riesgo los datos confidenciales de los pacientes y potencialmente exponen a la organización a riesgos regulatorios o legales.

3. Falta de formación

Establecer políticas de gobernanza en torno al uso ético de la IA tiene poco valor si no se comunican y refuerzan en toda la organización sanitaria. Al igual que las empresas establecen políticas de seguridad de datos o de uso aceptable e imparten formación periódica a su personal, las organizaciones sanitarias deben traducir las políticas de ética de la IA en formación práctica que pueda servir tanto a empleados nuevos como a veteranos.

Proporcionar una copia de la política a los empleados no es suficiente; los riesgos para la organización sanitaria (y sus pacientes) son demasiado altos. La organización debe diseñar e implementar una formación significativa en ética de la IA y hacerla obligatoria para todo el personal clínico y administrativo.

4. Falta de experiencia

Implementar estándares éticos de IA en un entorno sanitario puede ser abrumador, ya que requiere un amplio conocimiento de los sistemas de IA y un análisis detallado de la infraestructura informática de la organización. Por ejemplo, el departamento de TI debe implementar los mecanismos necesarios para proteger los datos almacenados (como la gestión de identidades y accesos o el cifrado de datos); los científicos de datos deben trabajar con diligencia para garantizar la calidad de los datos y mitigar los sesgos, tanto en la formación como en el uso práctico; y los profesionales deben reconocer y proteger los datos sensibles de los pacientes. Además, los expertos en sistemas de IA deben garantizar la transparencia y la explicabilidad del sistema para demostrar una comprensión completa de su comportamiento.

Todo esto exige un equipo experto que comprenda y apoye los esfuerzos de integración ética con los sistemas de IA. Una falta de experiencia, como la falta de explicabilidad del comportamiento de los sistemas de IA, puede comprometer las iniciativas de ética de la IA y poner en riesgo a la organización sanitaria.

Los riesgos del sesgo de la IA en la atención médica

La IA funciona procesando datos con una serie de algoritmos entrenados previamente con datos de ejemplo. Desafortunadamente, los mismos tipos de sesgo que experimentan los tomadores de decisiones humanos también pueden transmitirse a un sistema de IA a través del diseño de los algoritmos y los conjuntos de datos utilizados para prepararlos para su producción. Si bien el sesgo puede ser perjudicial en cualquier plataforma de IA, el sesgo en la IA puede tener profundos efectos en la demografía completa de los pacientes al subrepresentar posibles afecciones u ofrecer resultados subóptimos.

Un objetivo principal del desarrollo de cualquier sistema de IA es la identificación y mitigación del sesgo del sistema mediante medidas como la recopilación de datos exhaustivos de fuentes diversas y altamente inclusivas. Los tipos comunes de sesgo en IA incluyen los siguientes:

- Sesgo de evidencia (también conocido como sesgo de publicación o de informe ). Idealmente, los datos de IA son objetivos y transparentes, pero el sesgo de evidencia ocurre cuando factores externos distorsionan los datos que finalmente alimentan los sistemas de IA. Por ejemplo, la investigación financiada puede generar sesgo, ya que los resultados podrían inclinarse a favor de las fuentes de financiación. El mismo impacto ocurre cuando la investigación busca resultados positivos, lo que a veces resulta en una distorsión de los datos que favorece dichos resultados.

- Sesgo de experiencia (también conocido como sesgo de anotación o etiquetado ). Los profesionales clínicos y de la ciencia de datos pueden introducir etiquetas y clasificaciones de datos inconsistentes o incorrectas, lo que, en esencia, genera un sesgo indeseable en los datos de entrenamiento, así como en las tareas de entrenamiento y ajuste de algoritmos. Incluso los profesionales clínicos responsables de la clasificación de datos de pacientes pueden causar este sesgo inadvertidamente.

- Sesgo ambiental. Esta es una variante del sesgo de exclusión, en la que no se recopilan ni incluyen factores sociales, físicos y ambientales relacionados con los conjuntos de datos para añadir contexto vital a los datos del paciente. Por ejemplo, el sesgo ambiental puede ocurrir cuando se omiten detalles como la ubicación de residencia, las condiciones de vida, los ingresos y la educación en el conjunto total de datos.

- Sesgo de exclusión. La recopilación y el procesamiento de datos se ignoran o subrepresentan sistemáticamente. Por ejemplo, si se omiten del conjunto total de datos los datos correspondientes a un grupo demográfico específico de pacientes, la IA ofrecerá un rendimiento inferior para esos pacientes. Esto puede dar lugar a resultados como diagnósticos erróneos o no realizados y recomendaciones de tratamiento erróneas.

- Sesgo de empatía. El sesgo de empatía puede ocurrir cuando se omiten consideraciones subjetivas y emocionales —a menudo información cualitativa casi imposible de cuantificar— de los conjuntos de datos y del entrenamiento de la IA. Esto impide que la IA aporte contexto y matices a su toma de decisiones y a su consideración de las necesidades únicas de los pacientes y los grupos. Por ejemplo, no incluir las preferencias del paciente, como sus deseos al final de la vida, ni los valores morales o culturales, puede generar recomendaciones inapropiadas.

Existen tres estrategias para abordar el sesgo de la IA. Primero, garantizar que los conjuntos de datos representen fuentes diversas e inclusivas con amplios ejemplos y variabilidad. Segundo, garantizar la explicabilidad para que la toma de decisiones de la IA sea bien comprendida y fiable. Y tercero, utilizar un seguimiento exhaustivo para evaluar los resultados de la IA y detectar sesgos a medida que el sistema de IA continúa recibiendo nuevos datos y aprendiendo.

Fuente: www.techtarget.com